- ISBN:9787302678311

- 装帧:平装-胶订

- 册数:暂无

- 重量:暂无

- 开本:32开

- 页数:260

- 出版时间:2025-01-01

- 条形码:9787302678311 ; 978-7-302-67831-1

本书特色

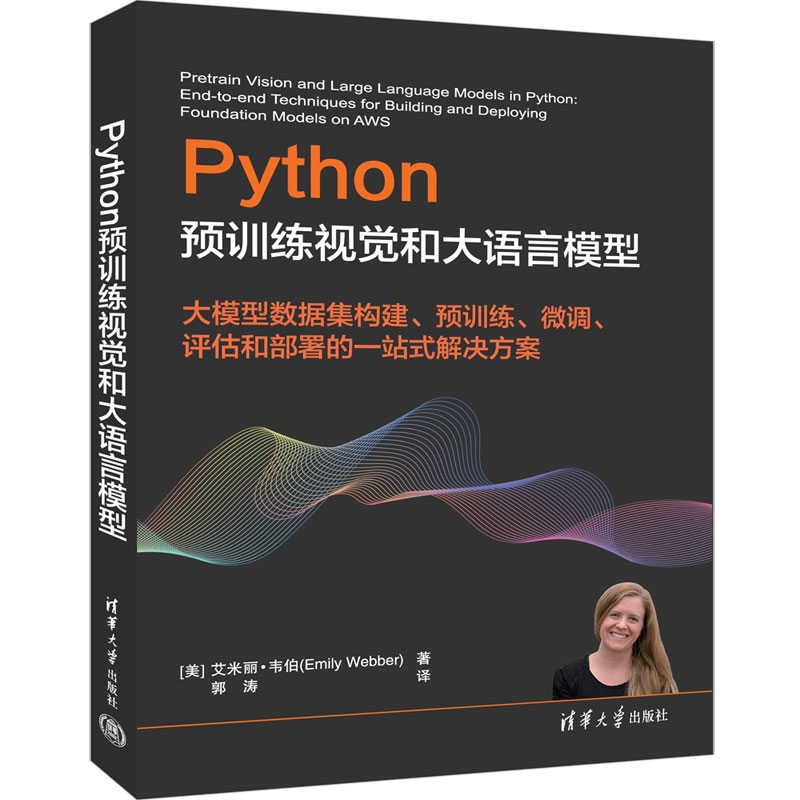

基础模型永久改变了机器学习。从BERT到ChatGPT,从CLIP到Stable Diffusion,当数十亿个参数、大数据集与成百上千个GPU相结合时,结果刷新了纪录。《Python预训练视觉和大语言模型》呈现的真知灼见和示例代码将帮你在AWS和Amazon SageMaker上从头开始预训练和优化基础模型,并将它们应用到整个组织的数百个用例中。

《Python预训练视觉和大语言模型》由经验丰富的AWS和机器学习专家Emily Webber撰写,涵盖的内容十分广泛,包括构思项目,准备数据集,训练、评估和部署大型语言、视觉及多模态模型。本书循序渐进地讲述基本概念并列举实例,指导你预训练和准备数据集及模型,配置环境,并训练、微调、评估、部署和优化基础模型。

学习本书后,你将能按照缩放法则在多个GPU上分布模型和数据集,消除偏差,实现高吞吐量以及构建部署管道。*后,你将完全有能力开发个人项目,对基础模型进行预训练和微调。

内容简介

●为预训练和微调寻找合适的用例和数据集

●使用定制的加速器和GPU,为大规模训练做好准备

●配置AWS和SageMaker环境,*大限度地提高性能

●根据模型和约束条件选择参数

●使用多种并行方式分发模型和数据集

●利用作业重启、间歇性健康检查等方式避开陷阱

●定性和定量地评估模型

●部署模型,在运行时进行改进和监控

目录

作者简介

Emily Webber是AWS的首席ML专家解决方案架构师,专门从事大型语言和视觉模型的分布式训练。Emily在AWS社区广为人知,在YouTube上发布了由16个视频组成的SageMaker系列,视频播放量高达21.1万次。Emily曾在2019年伦敦人工智能大会上发表过主题演讲。

-

而立.24

¥25.0¥56.8 -

我从未如此眷恋人间

¥16.9¥49.8 -

生死场

¥8.6¥36.0 -

那颗星星不在星图上-寻找太阳系的疆界

¥8.8¥29.0 -

快乐就是哈哈哈哈哈 插图纪念版

¥16.6¥52.0 -

梅子熟时栀子香

¥16.9¥49.8 -

文创幸存品-2023读者节金属书签

¥22.0¥45.0 -

饥饿、富裕与道德

¥12.2¥45.0 -

长安的荔枝

¥27.1¥45.0 -

生活的事实

¥13.2¥38.0 -

树会记住很多事

¥9.9¥29.8 -

告白

¥12.0¥36.8 -

林徽因讲建筑

¥10.3¥29.0 -

女性生存战争

¥20.8¥66.0 -

鱼河岸小店

¥14.5¥45.0 -

人性的因素

¥20.5¥65.0 -

阅读是一座随身携带的避难所

¥15.8¥39.0 -

守夜

¥14.3¥42.0 -

2024年读者节纪念徽章-一星会员专属-窥奇

¥45.0¥45.0 -

姑妈的宝刀

¥11.2¥30.0